AmericaSupermicroH100GPU

ITMALL.sale 擁有豐富的行業經驗和專業的技術團隊,能夠為客戶提供專業的 H100 GPU 咨詢和技術支持。ITMALL.sale 深知每個客戶的需求都是獨特的,因此在銷售過程中注重與客戶的溝通,了解其具體需求,提供量身定制的解決方案。ITMALL.sale 的技術團隊能夠幫助客戶快速部署和優化 H100 GPU 系統,確保其能夠充分發揮 H100 GPU 的強大性能,為客戶的業務發展提供強有力的支持。

ITMALL.sale 擁有完善的供應鏈和物流體系,確保客戶能夠快速、便捷地獲得 H100 GPU 產品。ITMALL.sale 與多家物流公司合作,能夠提供靈活的配送服務,滿足不同客戶的配送需求。無論是大批量采購還是小批量訂購,ITMALL.sale 都能夠確保產品及時送達。ITMALL.sale 的倉儲和物流團隊經過專業培訓,能夠高效、安全地處理每一筆訂單,確保產品在運輸過程中完好無損地送到客戶手中。 H100 GPU 支持 PCIe 4.0 接口。AmericaSupermicroH100GPU

每個GPU實例在整個內存系統中都有單獨的和孤立的路徑--片上的交叉開關端口、L2緩存庫、內存控制器和DRAM地址總線都是分配給單個實例的。這保證了單個用戶的工作負載可以以可預測的吞吐量和延遲運行,具有相同的L2緩存分配和DRAM帶寬,即使其他任務正在沖擊自己的緩存或使其DRAM接口飽和。H100MIG改進:提供完全安全的、云原生的多租戶、多用戶的配置。Transformer引擎Transformer模型是當今從BERT到GPT-3使用的語言模型的支柱,需要巨大的計算資源。第四代NVLink和NVLink網絡PCIe以其有限的帶寬形成了一個瓶頸。為了構建強大的端到端計算平臺,需要更快速、更可擴展的NVLink互連。NVLink是NVIDIA公司推出的高帶寬、高能效、低延遲、無損的GPU-to-GPU互連。其中包括彈性特性,如鏈路級錯誤檢測和數據包重放機制,以保證數據的成功傳輸。新的NVLink為多GPUIO和共享內存訪問提供了900GB/s的總帶寬,為PCIeGen5提供了7倍的帶寬。A100GPU中的第三代NVLink在每個方向上使用4個差分對(4個通道)來創建單條鏈路,在每個方向上提供25GB/s的有效帶寬,而第四代NVLink在每個方向上使用2個高速差分對來形成單條鏈路,在每個方向上也提供25GB/s的有效帶寬。引入了新的NVLink網絡互連。深圳訂購H100GPU購買 H100 GPU 享受限時特價。

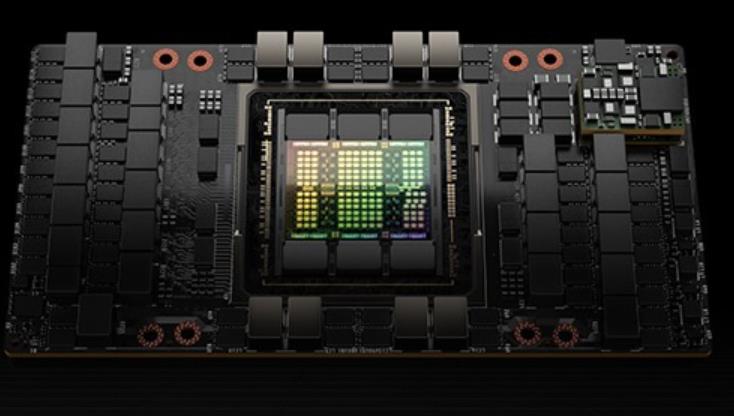

增加了一個稱為線程塊集群(ThreadBlockCluster)的新模塊,集群(Cluster)是一組線程塊(ThreadBlock),保證線程可以被并發調度,從而實現跨多個SM的線程之間的**協作和數據共享。集群還能更有效地協同驅動異步單元,如張量內存***(TensorMemoryAccelerator)和張量NVIDIA的異步事務屏障(“AsynchronousTransactionBarrier”)使集群中的通用CUDA線程和片上***能夠有效地同步,即使它們駐留在單獨的SM上。所有這些新特性使得每個用戶和應用程序都可以在任何時候充分利用它們的H100GPU的所有單元,使得H100成為迄今為止功能強大、可編程性強、能效高的GPU。組成多個GPU處理集群(GPUProcessingClusters,GPCs)TextureProcessingClusters(TPCs)流式多處理器(StreamingMultiprocessors,SM)L2CacheHBM3內存控制器GH100GPU的完整實現8GPUs9TPCs/GPU(共72TPCs)2SMs/TPC(共144SMs)128FP32CUDA/SM4個第四代張量/SM6HBM3/HBM2e堆棧。12個512位內存控制器60MBL2Cache第四代NVLink和PCIeGen5H100SM架構引入FP8新的Transformer引擎新的DPX指令H100張量架構專門用于矩陣乘和累加(MMA)數學運算的高性能計算,為AI和HPC應用提供了開創性的性能。

這些線程可以使用SM的共享內存與快速屏障同步并交換數據。然而,隨著GPU規模超過100個SM,計算程序變得更加復雜,線程塊作為編程模型中表示的局部性單元不足以大化執行效率。Cluster是一組線程塊,它們被保證并發調度到一組SM上,其目標是使跨多個SM的線程能夠有效地協作。GPC:GPU處理集群,是硬件層次結構中一組物理上總是緊密相連的子模塊。H100中的集群中的線程在一個GPC內跨SM同時運行。集群有硬件加速障礙和新的訪存協作能力,在一個GPC中SM的一個SM-to-SM網絡提供集群中線程之間快速的數據共享。分布式共享內存(DSMEM)通過集群,所有線程都可以直接訪問其他SM的共享內存,并進行加載(load)、存儲(store)和原子(atomic)操作。SM-to-SM網絡保證了對遠程DSMEM的快速、低延遲訪問。在CUDA層面,集群中所有線程塊的所有DSMEM段被映射到每個線程的通用地址空間中。使得所有DSMEM都可以通過簡單的指針直接引用。DSMEM傳輸也可以表示為與基于共享內存的障礙同步的異步復制操作,用于**完成。異步執行異步內存拷貝單元TMA(TensorMemoryAccelerator)TMA可以將大塊數據和多維張量從全局內存傳輸到共享內存,反義亦然。使用一個copydescriptor。H100 GPU 降價特惠,先到先得。

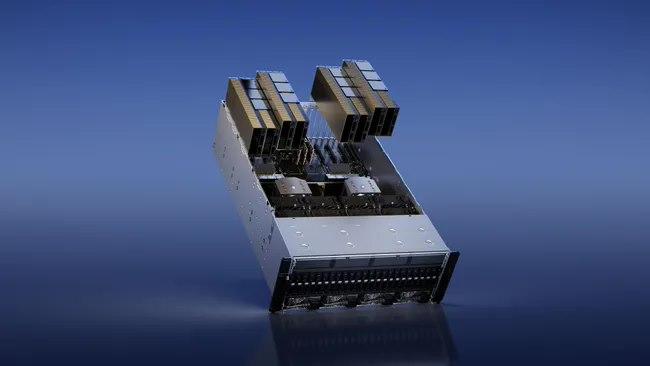

在大預言模型中達到9倍的AI訓練速度和30倍的AI推理速度。HBM3內存子系統提供近2倍的帶寬提升。H100SXM5GPU是世界上款采用HBM3內存的GPU,其內存帶寬達到3TB/sec。50MB的L2Cache架構緩存了大量的模型和數據以進行重復訪問,減少了對HBM3的重復訪問次數。第二代多實例GPU(Multi-InstanceGPU,MIG)技術為每個GPU實例提供約3倍的計算能量和近2倍的內存帶寬。次支持機密計算,在7個GPU實例的虛擬化環境中支持多租戶、多用戶配置。(MIG的技術原理:作業可同時在不同的實例上運行,每個實例都有的計算、顯存和顯存帶寬資源,從而實現可預測的性能,同時符合服務質量(QoS)并盡可能提升GPU利用率。)新的機密計算支持保護用戶數據,防御硬件和軟件攻擊,在虛擬化和MIG環境中更好的隔離和保護虛擬機。H100實現了世界上個國產的機密計算GPU,并以全PCIe線速擴展了CPU的可信執行環境。第四代NVIDIANVLink在全歸約操作上提供了3倍的帶寬提升,在7倍PCIeGen5帶寬下,為多GPUIO提供了900GB/sec的總帶寬。比上一代NVLink增加了50%的總帶寬。第三代NVSwitch技術包括駐留在節點內部和外部的交換機,用于連接服務器、集群和數據中心環境中的多個GPU。H100 GPU 限時特惠,立刻下單。湖南H100GPU price

H100 GPU 特惠價格,先到先得。AmericaSupermicroH100GPU

L2CacheHBM3內存控制器GH100GPU的完整實現8GPUs9TPCs/GPU(共72TPCs)2SMs/TPC(共144SMs)128FP32CUDA/SM4個第四代張量/SM6HBM3/HBM2e堆棧,12個512位內存控制器60MBL2Cache第四代NVLink和PCIeGen5H100SM架構引入FP8新的Transformer引擎新的DPX指令H100張量架構專門用于矩陣乘和累加(MMA)數學運算的高性能計算,為AI和HPC應用提供了開創性的性能。H100中新的第四代TensorCore架構提供了每SM的原始稠密和稀疏矩陣數學吞吐量的兩倍支持FP8、FP16、BF16、TF32、FP64、INT8等MMA數據類型。新的TensorCores還具有更**的數據管理,節省了高達30%的操作數交付能力。FP8數據格式與FP16相比,FP8的數據存儲需求減半,吞吐量提高一倍。新的TransformerEngine(在下面的章節中進行闡述)同時使用FP8和FP16兩種精度,以減少內存占用和提高性能,同時對大型語言和其他模型仍然保持精度。用于加速動態規劃(“DynamicProgramming”)的DPX指令新引入的DPX指令為許多DP算法的內循環提供了高等融合操作數的支持,使得動態規劃算法的性能相比于AmpereGPU高提升了7倍。L1數據cache和共享內存結合將L1數據cache和共享內存功能合并到單個內存塊中簡化了編程。AmericaSupermicroH100GPU

- 佛山2960X-24PD-L交換機停產 2025-01-24

- 佛山2960X-48TD-L交換機優惠 2025-01-24

- WS-C2960X-48TS-L交換機 2025-01-23

- 海南2960X-48TD-L交換機代理商 2025-01-23

- PWR-C1-350WAC-P交換機購買 2025-01-22

- 肇慶9200L交換機優惠 2025-01-22

- C9200L-24P-4X-E交換機產品價格 2025-01-21

- 肇慶思科交換機端口數 2025-01-21

- C1000-48P-4G-L交換機多少錢 2025-01-20

- Cisco交換機維修 2025-01-20

- 廣西手機信號增強器效果 2025-01-26

- 安徽防爆調度機詢問報價 2025-01-26

- 北京KTH186雙回路電話 2025-01-26

- 重慶無限流量隨身wifi加盟哪個好 2025-01-26

- 多芯光纖連接器有哪些種類 2025-01-26

- 火車站售貨機游戲 2025-01-26

- 南朗鎮互動光纖開通 2025-01-26

- 規約轉換器IEC61850CMS一般價格 2025-01-26

- 多芯光纖連接器 LC/PC報價 2025-01-26

- 浙江自動售貨機優勢 2025-01-26