技嘉H100GPU多少錢一臺

他們與來自大云(Azure,GoogleCloud,AWS)的一些人交談,試圖獲得許多H100。他們發現他們無法從大云中獲得大量分配,并且一些大云沒有良好的網絡設置。因此,他們與其他提供商(如CoreWeave,Oracle,Lambda,FluidStack)進行了交談。如果他們想自己購買GPU并擁有它們,也許他們也會與OEM和Nvidia交談。終,他們獲得了大量的GPU。現在,他們試圖獲得產品市場契合度。如果不是很明顯,這條途徑就沒有那么好了-請記住,OpenAI在更小的模型上獲得了產品市場契合度,然后將它們擴大了規模。但是,現在要獲得產品市場契合度,您必須比OpenAI的模型更適合用戶的用例,因此首先,您將需要比OpenAI開始時更多的GPU。預計至少到100年底,H2023將短缺數百或數千次部署。到2023年底,情況將更加清晰,但就目前而言,短缺似乎也可能持續到2024年的某些時間。GPU供需之旅。大版本取得聯系#作者:克萊·帕斯卡。問題和筆記可以通過電子郵件發送。新帖子:通過電子郵件接收有關新帖子的通知。幫助:看這里。自然的下一個問題-英偉達替代品呢?#自然的下一個問題是“好吧,競爭和替代方案呢?我正在探索硬件替代方案以及軟件方法。提交我應該探索的東西作為此表格的替代方案。例如。H100 GPU 降價促銷,機會難得。技嘉H100GPU多少錢一臺

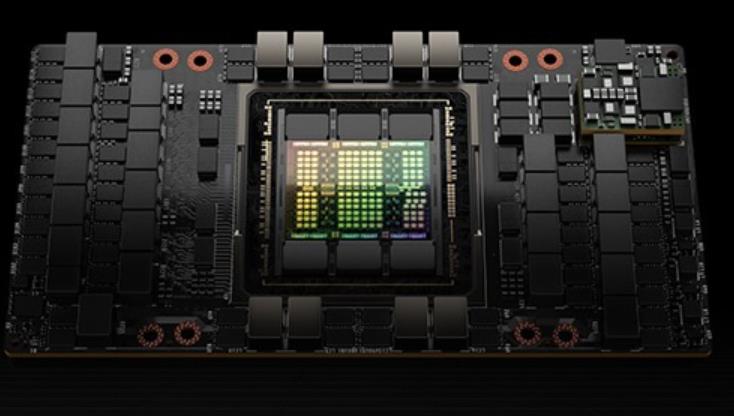

每個GPU實例在整個內存系統中都有單獨的和孤立的路徑--片上的交叉開關端口、L2緩存庫、內存控制器和DRAM地址總線都是分配給單個實例的。這保證了單個用戶的工作負載可以以可預測的吞吐量和延遲運行,具有相同的L2緩存分配和DRAM帶寬,即使其他任務正在沖擊自己的緩存或使其DRAM接口飽和。H100MIG改進:提供完全安全的、云原生的多租戶、多用戶的配置。Transformer引擎Transformer模型是當今從BERT到GPT-3使用的語言模型的支柱,需要巨大的計算資源。第四代NVLink和NVLink網絡PCIe以其有限的帶寬形成了一個瓶頸。為了構建強大的端到端計算平臺,需要更快速、更可擴展的NVLink互連。NVLink是NVIDIA公司推出的高帶寬、高能效、低延遲、無損的GPU-to-GPU互連。其中包括彈性特性,如鏈路級錯誤檢測和數據包重放機制,以保證數據的成功傳輸。新的NVLink為多GPUIO和共享內存訪問提供了900GB/s的總帶寬,為PCIeGen5提供了7倍的帶寬。A100GPU中的第三代NVLink在每個方向上使用4個差分對(4個通道)來創建單條鏈路,在每個方向上提供25GB/s的有效帶寬,而第四代NVLink在每個方向上使用2個高速差分對來形成單條鏈路,在每個方向上也提供25GB/s的有效帶寬。引入了新的NVLink網絡互連。硬盤H100GPU現貨H100 GPU 支持 PCIe 4.0 接口。

H100 GPU 市場價格的變化主要受供需關系和外部環境的影響。當前,人工智能和大數據分析的快速發展推動了對 H100 GPU 的需求,導致市場價格上漲。同時,全球芯片短缺和供應鏈問題也對 H100 GPU 的價格產生了不利影響。盡管如此,隨著市場供需關系的逐步平衡和供應鏈的恢復,預計 H100 GPU 的價格將逐漸趨于平穩。對于計劃采購 H100 GPU 的企業和研究機構來說,關注市場價格動態和供應鏈狀況,有助于制定更加科學的采購決策。H100 GPU 市場需求的增長推動了價格的波動。隨著人工智能和大數據分析的興起,H100 GPU 在高性能計算中的應用越來越,這直接導致了市場對其需求的激增。供應鏈的緊張局面以及生產成本的上漲,也進一步推高了 H100 GPU 的市場價格。目前,市場上 H100 GPU 的價格相較于發布初期已有提升,特別是在一些專業領域和大規模采購項目中,價格上漲尤為明顯。然而,隨著市場的逐漸穩定和供應鏈的優化,H100 GPU 的價格可能會在未來一段時間內趨于平穩。

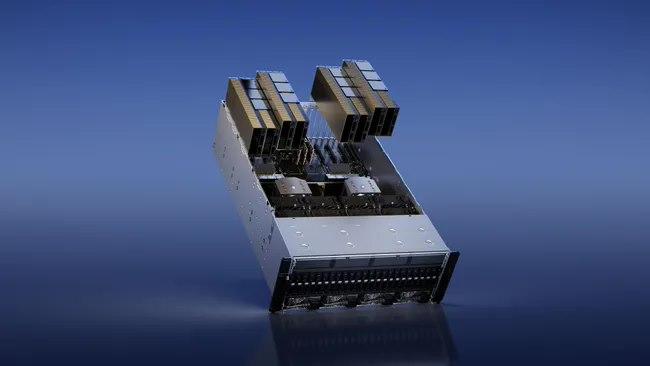

以提供SHARP在網絡中的縮減和任意對GPU之間900GB/s的完整NVLink帶寬。H100SXM5GPU還被用于功能強大的新型DGXH100服務器和DGXSuperPOD系統中。H100PCIeGen5GPU以有350W的熱設計功耗(ThermalDesignPower,TDP),提供了H100SXM5GPU的全部能力該配置可選擇性地使用NVLink橋以600GB/s的帶寬連接多達兩個GPU,接近PCIeGen5的5倍。H100PCIe非常適合主流加速服務器(使用標準的架構,提供更低服務器功耗),為同時擴展到1或2個GPU的應用提供了很好的性能,包括AIInference和一些HPC應用。在10個前列數據分析、AI和HPC應用程序的數據集中,單個H100PCIeGPU**地提供了H100SXM5GPU的65%的交付性能,同時消耗了50%的功耗。DGXH100andDGXSuperPODNVIDIADGXH100是一個通用的高性能人工智能系統,用于訓練、推理和分析。配置了Bluefield-3,NDRInfiniBand和第二代MIG技術單個DGXH100系統提供了16petaFLOPS(千萬億次浮點運算)(FP16稀疏AI計算性能)。通過將多個DGXH100系統連接組成集群(稱為DGXPODs或DGXSuperPODs)。DGXSuperPOD從32個DGXH100系統開始,被稱為"可擴展單元"集成了256個H100GPU,這些GPU通過基于第三代NVSwitch技術的新的二級NVLink交換機連接。能夠實現更加復雜和逼真的游戲畫面。

這些線程可以使用SM的共享內存與快速屏障同步并交換數據。然而,隨著GPU規模超過100個SM,計算程序變得更加復雜,線程塊作為編程模型中表示的局部性單元不足以大化執行效率。Cluster是一組線程塊,它們被保證并發調度到一組SM上,其目標是使跨多個SM的線程能夠有效地協作。GPC:GPU處理集群,是硬件層次結構中一組物理上總是緊密相連的子模塊。H100中的集群中的線程在一個GPC內跨SM同時運行。集群有硬件加速障礙和新的訪存協作能力,在一個GPC中SM的一個SM-to-SM網絡提供集群中線程之間快速的數據共享。分布式共享內存(DSMEM)通過集群,所有線程都可以直接訪問其他SM的共享內存,并進行加載(load)、存儲(store)和原子(atomic)操作。SM-to-SM網絡保證了對遠程DSMEM的快速、低延遲訪問。在CUDA層面,集群中所有線程塊的所有DSMEM段被映射到每個線程的通用地址空間中。使得所有DSMEM都可以通過簡單的指針直接引用。DSMEM傳輸也可以表示為與基于共享內存的障礙同步的異步復制操作,用于**完成。異步執行異步內存拷貝單元TMA(TensorMemoryAccelerator)TMA可以將大塊數據和多維張量從全局內存傳輸到共享內存,反義亦然。使用一個copydescriptor。H100 GPU 提供 312 TFLOPS 的 Tensor Core 性能。湖北H100GPU現貨

H100 GPU 的高性能計算能力為此類任務提供了極大支持。技嘉H100GPU多少錢一臺

在大預言模型中達到9倍的AI訓練速度和30倍的AI推理速度。HBM3內存子系統提供近2倍的帶寬提升。H100SXM5GPU是世界上款采用HBM3內存的GPU,其內存帶寬達到3TB/sec。50MB的L2Cache架構緩存了大量的模型和數據以進行重復訪問,減少了對HBM3的重復訪問次數。第二代多實例GPU(Multi-InstanceGPU,MIG)技術為每個GPU實例提供約3倍的計算能量和近2倍的內存帶寬。次支持機密計算,在7個GPU實例的虛擬化環境中支持多租戶、多用戶配置。(MIG的技術原理:作業可同時在不同的實例上運行,每個實例都有的計算、顯存和顯存帶寬資源,從而實現可預測的性能,同時符合服務質量(QoS)并盡可能提升GPU利用率。)新的機密計算支持保護用戶數據,防御硬件和軟件攻擊,在虛擬化和MIG環境中更好的隔離和保護虛擬機。H100實現了世界上個國產的機密計算GPU,并以全PCIe線速擴展了CPU的可信執行環境。第四代NVIDIANVLink在全歸約操作上提供了3倍的帶寬提升,在7倍PCIeGen5帶寬下,為多GPUIO提供了900GB/sec的總帶寬。比上一代NVLink增加了50%的總帶寬。第三代NVSwitch技術包括駐留在節點內部和外部的交換機,用于連接服務器、集群和數據中心環境中的多個GPU。技嘉H100GPU多少錢一臺

- N9K-C93180YC-FX3 多少錢 2024-12-23

- A900-IMA1C 深圳代理 2024-12-23

- N9K-C9508-FAN-PWR 廠家 2024-12-20

- 80GH100GPU優惠 2024-12-20

- N9K-C93180YC-FX3 broker 2024-12-19

- 海南2960X-48TD-L交換機維修 2024-12-19

- 佛山Cisco交換機價格 2024-12-18

- 中山思科交換機價格 2024-12-18

- C1000-48T-4G交換機報價 2024-12-17

- 惠州2960X-48TD-L交換機參數 2024-12-17

- 和平區易使用網絡時間服務設備 2024-12-23

- 泉州安全人員報警防爆手機 2024-12-23

- 青海無源目標識別創意 2024-12-23

- 上海自動派樣機分賬 2024-12-23

- 寧波石化作業票防爆手機供應商 2024-12-23

- 蘇州pc端加速器網站 2024-12-23

- 坦洲鎮大流量電信寬帶開通 2024-12-23

- 企業視頻彩鈴加盟平臺 2024-12-23

- 廣州工業巡檢防爆手機制造商 2024-12-23

- 江蘇工廠派樣機營銷 2024-12-23